L’apprentissage automatique est omniprésent. C’est grâce à cette technologie, par exemple, que Spotify vous suggère des titres à écouter ou que Siri répond à vos questions. Elle est également utilisée en physique des particules, notamment pour les calculs théoriques et l’analyse des données. Une équipe composée de chercheurs du CERN et de Google a mis au point une nouvelle technique permettant d’accélérer les réseaux neuronaux profonds – forme d’algorithme d’apprentissage automatique – afin de sélectionner les collisions proton-proton auprès du Grand collisionneur de hadrons (LHC) à des fins d’analyse ultérieure. Cette technique, décrite dans un article qui vient d’être publié dans la revue Nature Machine Intelligence, pourrait également être utilisée au-delà de la physique des particules.

Les détecteurs de particules situés le long de l’anneau du LHC utilisent un matériel électronique de « déclenchement » qui permet de sélectionner les collisions de particules potentiellement intéressantes à des fins d’analyse ultérieure. Avec un taux de collisions proton-proton au LHC pouvant atteindre actuellement 1 milliard de collisions par seconde, le logiciel qui est utilisé aujourd’hui par les systèmes de déclenchement des détecteurs choisit de sélectionner ou non une collision dans le délai imparti, qui est d’à peine une microseconde. Or, le taux de collision devant être multiplié par un facteur de 5 à 7 avec le futur HL-LHC (LHC à haute luminosité), les chercheurs étudient d’autres solutions logicielles qui pourraient rendre ce choix plus rapide, notamment des algorithmes d’apprentissage automatique.

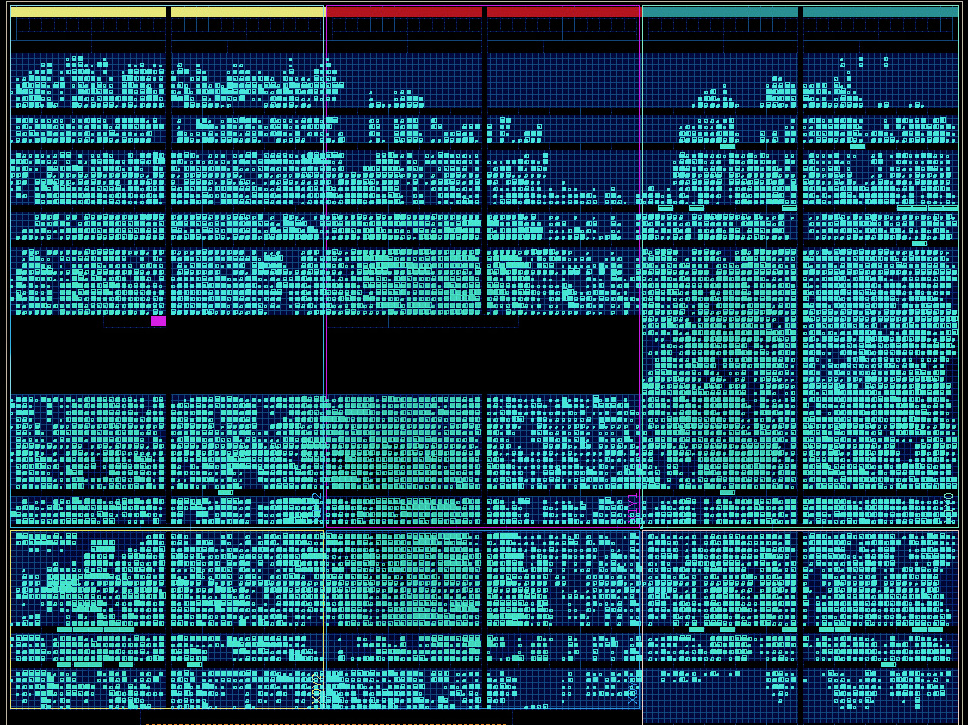

C’est là qu’intervient la nouvelle étude des chercheurs du CERN et de leurs collaborateurs ; celle-ci tire parti de travaux menés précédemment, qui ont donné naissance à un outil logiciel permettant de déployer des réseaux neuronaux profonds sur un matériel appelé dispositifs logiques programmables (FPGA), qui peut être programmé pour exécuter différentes tâches, notamment la sélection de collisions de particules intéressantes. Les chercheurs du CERN et leurs collègues ont mis au point une technique permettant de réduire la taille d’un réseau neuronal profond d’un facteur 50 et d’obtenir un temps de traitement du réseau de quelques dizaines de nanosecondes, soit bien moins que le temps à disposition pour sélectionner ou écarter une collision.

« La technique revient à compresser le réseau neuronal profond en réduisant la précision numérique des paramètres qui le définissent, explique Vladimir Loncar, co-auteur de l’étude et chercheur au CERN. Cette opération est effectuée lors de la phase de formation ou d’apprentissage du réseau, ce qui permet au réseau de s’adapter au changement. Il est ainsi possible de réduire la taille du réseau et le temps de traitement, sans perte de performance du réseau. »

En outre, cette technique permet de déterminer la précision numérique la plus adaptée au regard de certaines contraintes matérielles, comme la quantité de ressources matérielles disponibles.

De plus, elle présente l’avantage d’être accessible aux non-spécialistes et de pouvoir être utilisée sur des dispositifs logiques programmables (FPGA) dans des détecteurs de particules et d’autres appareils ayant besoin de réseaux de petite taille offrant un temps de traitement rapide.

Par la suite, les chercheurs souhaiteraient utiliser leur technique pour concevoir un nouveau type de système de déclenchement permettant de sélectionner des collisions qui seraient normalement écartées par un système de déclenchement conventionnel, mais qui pourraient cacher de nouveaux phénomènes. « L’objectif ultime est de pouvoir détecter des collisions qui pourraient indiquer une nouvelle physique au-delà du Modèle standard de la physique des particules », explique Thea Aarrestad, également co-auteure de l’étude et chercheuse au CERN.